Leistungsstarke KI-Server für Ihre anspruchsvollsten Workloads

Von Edge bis Hyperscale – KI-Systeme aus einer Hand

Ihre KI-Reise beginnt hier

Mit den MH KI Server- und Rechenzentrumslösungen erhalten Unternehmen jeder Größe Zugriff auf performante, skalierbare und vollständig integrierte KI-Infrastrukturen. Ob als schlüsselfertiges Komplettsystem, flexibler AI Data Centre Cluster oder kompakte Workstation – unsere Lösungen sind auf höchste Energieeffizienz, sofortige Einsatzbereitschaft und Zukunftssicherheit ausgelegt. Ideal für anspruchsvolle Anwendungen wie maschinelles Lernen, Deep Learning, Computer Vision und generative KI.

Unsere Lösungen im Überblick

Turnkey Systeme

Komplettlösungen mit vorinstallierter Software und AI-Stack. Direkt einsatzbereit. Ideal für Unternehmen, die schnell und zuverlässig produktive KI-Infrastruktur benötigen - ohne eigenen Integrationsaufwand.

Anwendungsbeispiele:

- Echtzeit-Inferenz bei Videoanalyse / Object Detection: Objekterkennung oder Gesichtserkennung in Sicherheitssystemen etwa zur Auslösung von Automatisierungen über Kamera-Feeds. CPUs sind hier oft zu langsam – GPUs erledigen diese Tasks effizient und parallel.

- Generative AI (Stable Diffusion, Bildsynthese): Kleine bis mittlere Bildgeneratoren oder Codegeneratoren (z.B. Stable Diffusion), die auf kompakten GPU-Hardwarelösungen betrieben werden.

- Computer Vision & Sensorfusion im Edge-Umfeld: Automatisierte Bilderkennung, Videoanalyse, Predictive Maintenance oder Produktionsüberwachung direkt vor Ort – in Echtzeit ohne Cloud-Latenz.

- Batch-Inferenz & Feature Engineering für ML Pipelines: Viele kleinere Vorhersagen oder DNN-Auswertungen parallel verarbeiten — wie bei Predictive Analytics oder Modellbatching — bieten hohe GPU-Auslastung.

AI Data Centre

Vollintegrierte, skalierbare Rechenzentren für Hochleistungs-KI-Anwendungen.

Anwendungsbeispiele:

- Generative AI (Stable Diffusion, Bildsynthese): Große Bildgeneratoren oder Codegeneratoren (z.B. Stable Diffusion), die auf skalierbaren GPU-Lösungen betrieben werden.

- ML/AI-Forschung oder Training: Kontext wie z.B. CSV-Datensätze oder Training großer Modelle auf verteilter GPU Infrastruktur Server. CPUs helfen beim Pre-Processing, GPUs beim Training.

Standalone Hardware

GPU-Server, Workstations und Komponenten für Ihre eigene Infrastruktur.

Anwendungsbeispiele:

- Lokale LLM-Modelle & Chatbots: z.B. llama.cpp oder kleinere LLMs, die auf kompakter Hardware ausgeführt werden - zur Beantwortung einfacher Textanfragen oder Steuerung per Chatbot.

- Inference & Fine-Tuning kleinerer Sprachmodelle: Edge-Inferenz von NLP-Modellen, wie Sentiment-Analyse oder kleinere Sprach-LLMs - besonders effizient auf dedizierten GPU-Servern.

Hardware & Service aus einer Hand

Bei MH Service erhalten Sie nicht nur leistungsstarke KI-Hardware, sondern auch umfassende Unterstützung - von der Bedarfsanalyse über Integration bis zum Betrieb. Unsere Expertenteams begleiten Sie bei der Planung, Dimensionierung und dem Rollout Ihrer KI-Infrastruktur – on-premises oder in der Cloud. Optional erhalten Sie vorkonfigurierte Systeme mit vorinstallierten Modellen, Frameworks und Security-Komponenten, angepasst an Ihre Use-Cases.

AI Ready

DGX Station

A powerful desktop AI supercomputer with the Grace Blackwell GB300 Superchip and 784GB unified memory, built for enterprise-grade AI training and inference. Perfect for intensive workloads at your desk.

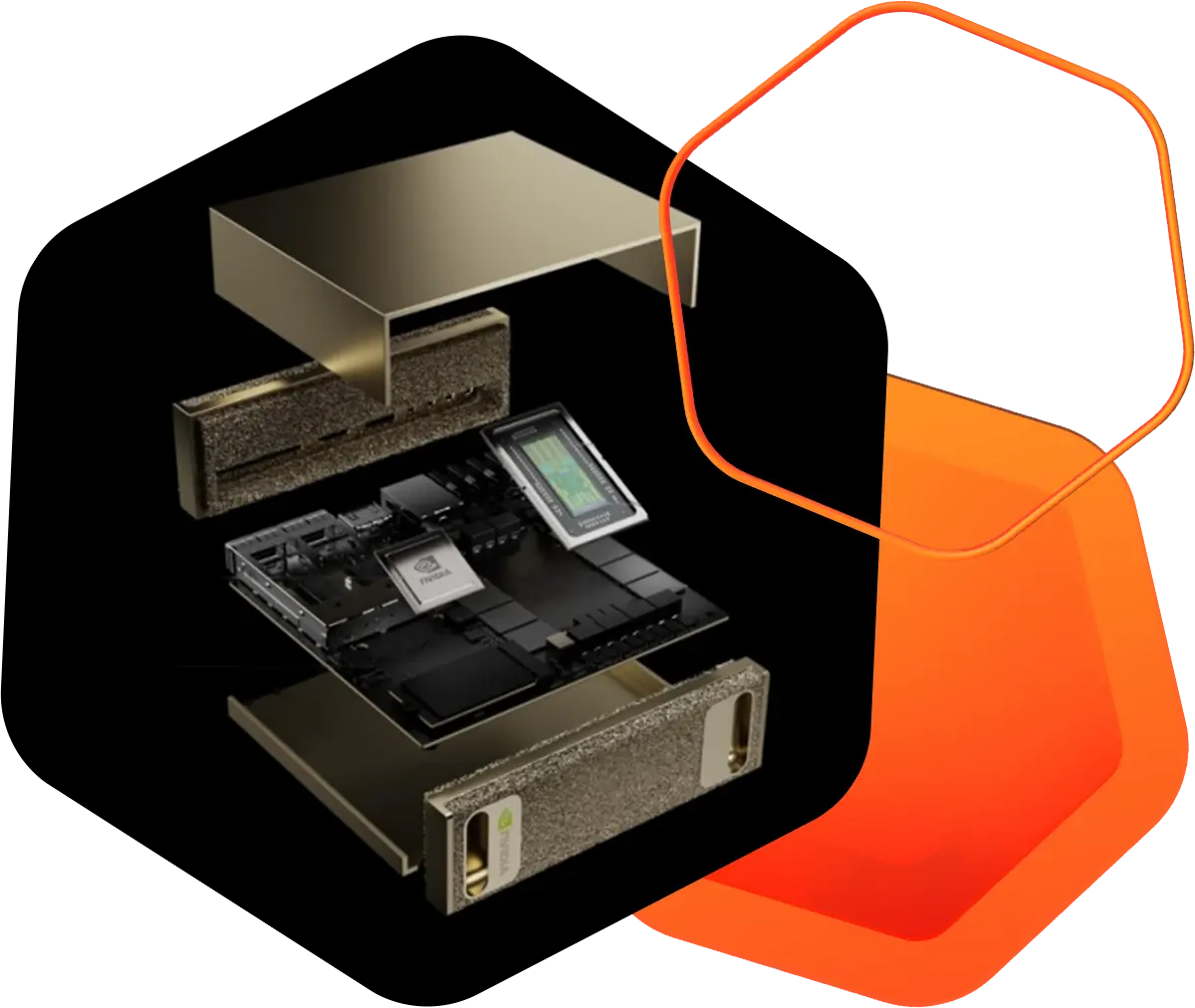

DGX Spark

The world’s smallest AI supercomputer with the Grace Blackwell GB10, delivering 1 petaflop of performance and 128GB memory for local AI prototyping, fine-tuning, and inference, scalable to data centres or cloud.

Enterprise KI-Server

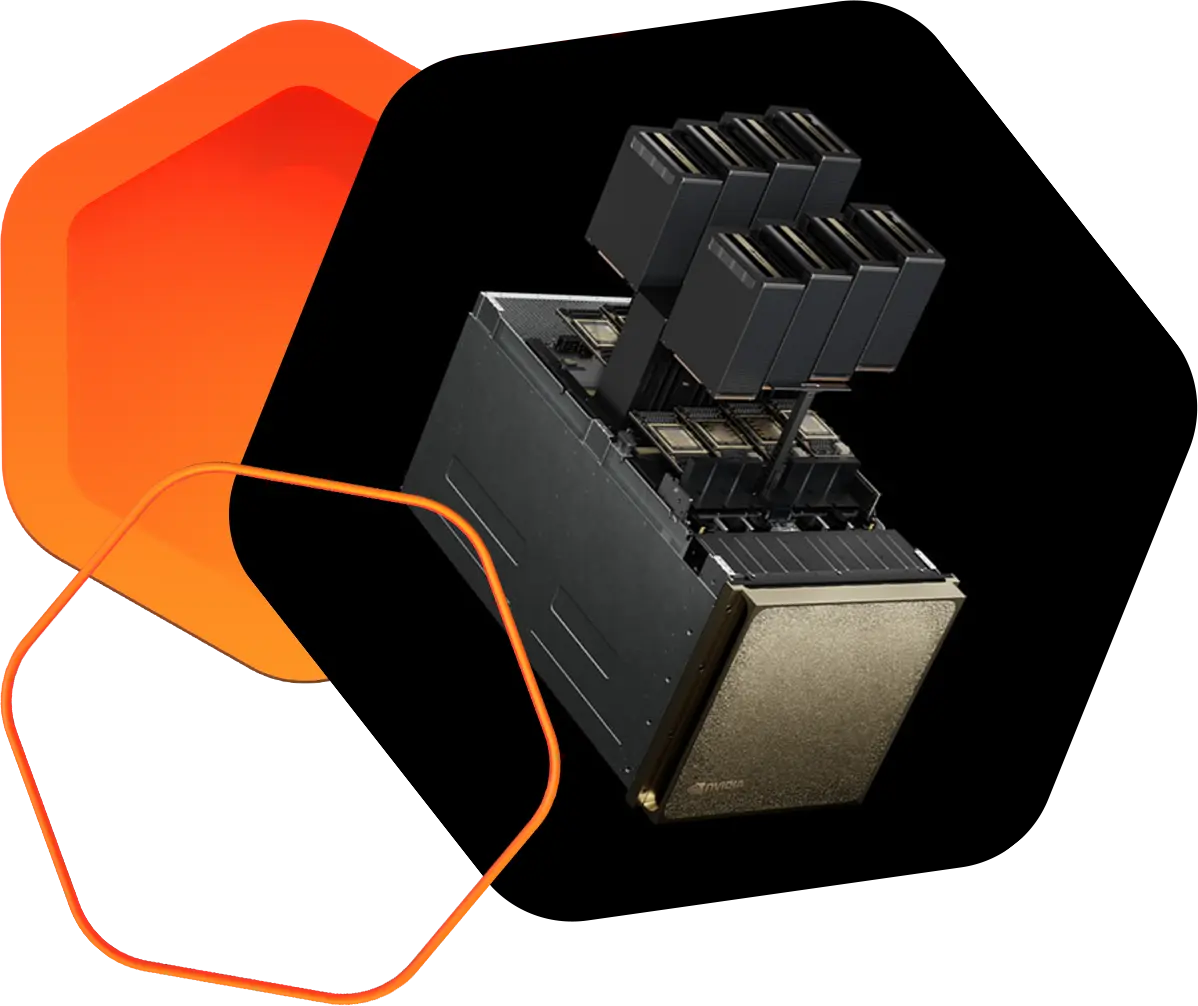

DGX B200 Server

A powerful AI server with 8 Blackwell GPUs and next-gen NVLink™, offering 3× faster training and 15× better inference. Built for enterprise-scale AI and model deployment.

DGX B300 Server

A high-performance AI system with Blackwell Ultra GPUs, delivering up to 144 PFLOPS inference and 72 PFLOPS training—built for generative AI, reasoning, and seamless data centre integration.

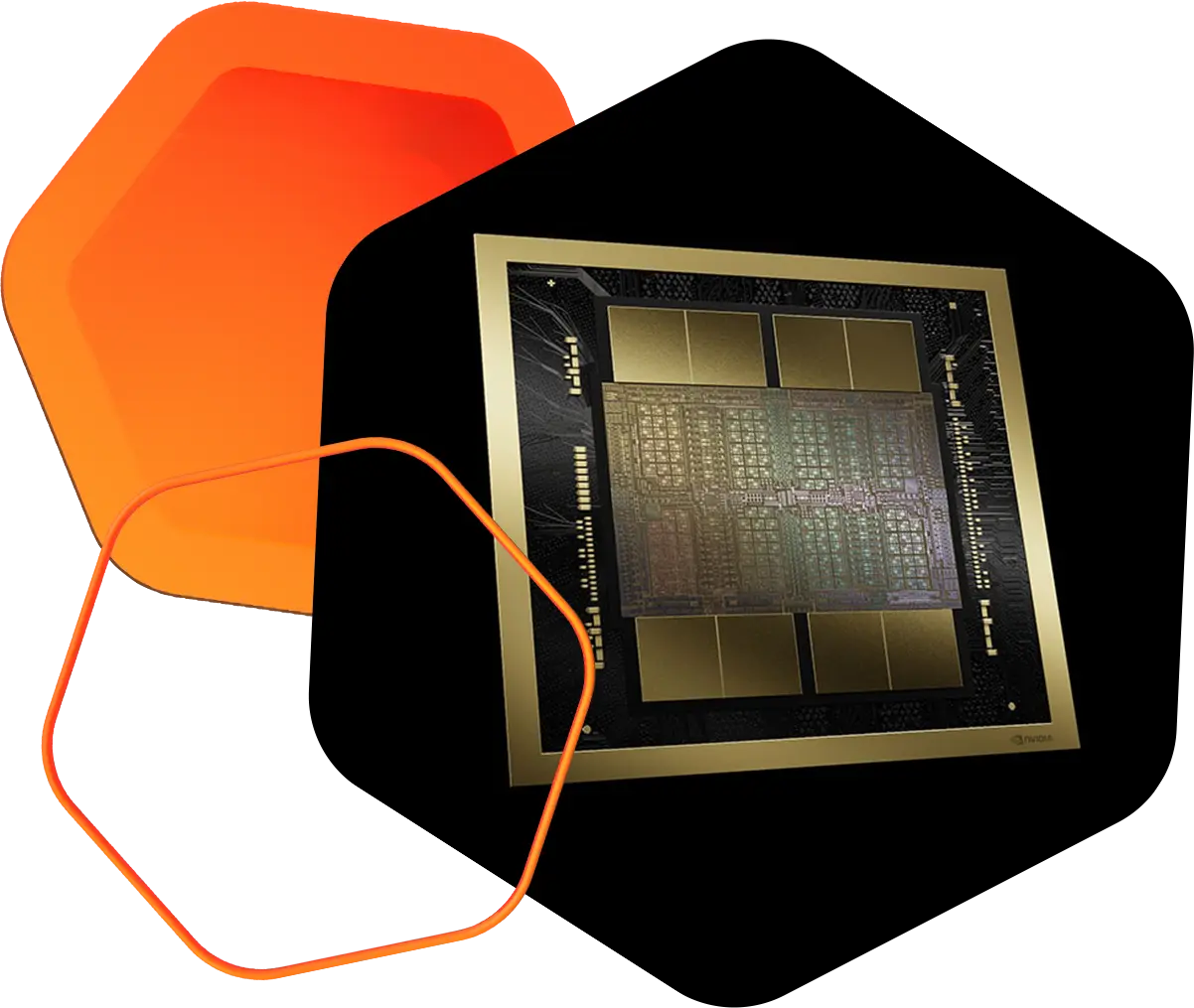

AI Factory

AI Factory (Blackwell, Grace, Bluefield): A next-gen AI infrastructure with powerful GPUs, advanced networking, and efficient design—built to accelerate reasoning and inference at scale across industries.